- La vie, la mort, le dessertSatosphèreDates: Du 18 au 21 février et du 25 au 28 février

Plusieurs dates à venir en novembre et décembre

Heure: 18h

Durée: environ 3h

Les représentations prévues du 20 au 28 février rejoignent officiellement la programmation gourmande de Montréal en Lumière. - Club SAT x Groovy Castle — Fred Everything • Lia Plutonic • JP GrooveEspace SAT22h-3h

Quand l’interactivité transforme l’expérience immersive et collective

Par Manuel Bolduc, Alexandra Marin et Zachary L’Heureux

À la Société des arts technologiques [SAT], la recherche est multidisciplinaire et appliquée. Les projets d’innovation de la SAT touchent autant au développement de prototypes technologiques inusités qu’à la mise en production de nouvelles formes créatives destinées à la production de spectacles. Avec son approche collaborative, la SAT contribue au partage des connaissances et à l’établissement de nouvelles pratiques dans le milieu de la créativité numérique montréalaise et au-delà.

Manuel Bolduc, chercheur-développeur au département d’innovation de la SAT, nous parle d’un sujet qui gagne en intérêt dans l’écosystème de la créativité numérique, soit la conception d’expériences immersives interactives. En effet, de plus en plus de créateur·trices souhaitent mettre à profit l’utilisation de nouvelles technologies pour augmenter l’engagement du public dans des expériences numériques, des installations artistiques, et des performances.

Myron Krueger, pionnier de l’art interactif tel qu’on le connaît aujourd’hui, constitue une référence de choix et un cadre intéressant pour imaginer ces expériences immersives interactives. Dans son livre Artificial reality (1983), notamment, il décrit en détail les principes d’interactivité qu’il a intégré dans différentes installations artistiques. Il utilise le terme responsive environment, véhiculant l’idée que des environnements physiques puissent être augmentés d’un système de senseurs et d’émetteurs afin d’établir une communication avec les individus présents dans l’espace.

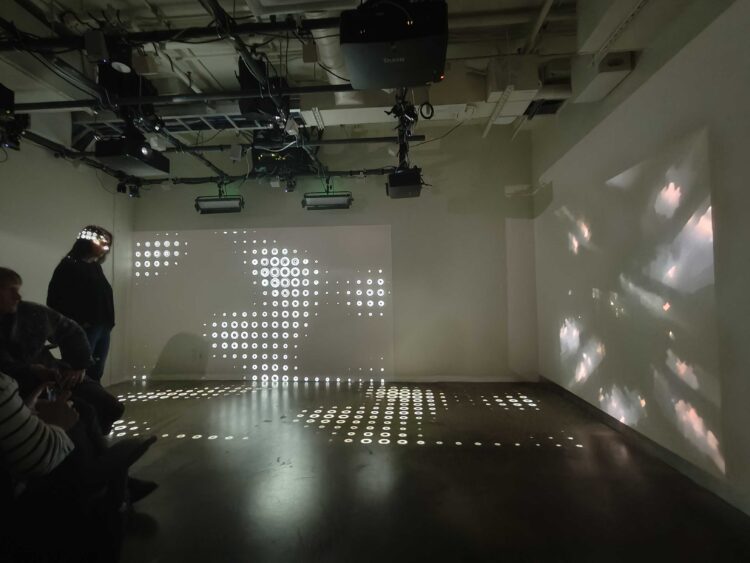

Cette notion est mise de l’avant dans son œuvre intitulée Psychic Space (1971), qui prend place dans une salle avec un plancher couvert de senseurs. Ces senseurs sont connectés à un système de haut-parleurs, ainsi qu’à un écran de projection situé au fond de la salle. Le dialogue entre les participant·es de l’installation et l’environnement physique s’établit autour de deux modalités de communication, soit l’émission de sons et la projection visuelle. Lorsque les participant·es se déplacent, ils et elles déclenchent différents sons et peuvent ainsi jouer de la musique, selon leur positionnement dans la salle. Le déplacement des participant·es est également représenté par un curseur sur l’écran de projection. Une fois les principes de communication visuels et auditifs établis entre l’espace et les participant·es, le dialogue peut s’enrichir en faisant évoluer la manière dont l’environnement physique réagit au déplacement des participant·es.

Cinquante ans après la réalisation de Psychic space, la conception d’expériences immersives interactives est facilitée par les avancées technologiques dans le domaine de la vision par ordinateur et de la réalité augmentée, ouvrant la voie à une prolifération de ces créations et la participation d’un public toujours plus nombreux.

L’écosystème créatif montréalais à l’ère de l’interactivité

Grâce à son écosystème créatif en constante effervescence, Montréal constitue un terrain propice à l’élaboration de ce type d’expériences. En plein cœur de Montréal, le Quartier des spectacles a présenté plusieurs installations interactives pour le public. On peut penser à l’installation Waterfalls, du studio Iregular, ou encore à l’installation Marche marche danse du studio Daily tous les jours.

Projections interactives sur la patinoire de l’Esplanade tranquille. Crédit: Ulysse Lemerise

L’accessibilité croissante de capteurs de profondeur abordables, tels que les Kinect Azure, intel RealSense ou encore les ORBBEC Femto Mega, joue un rôle important dans la démocratisation des expériences immersives interactives. Bien qu’ils n’aient pas été conçus spécifiquement pour cet usage, ces capteurs sont pertinents et adaptés pour obtenir de l’information en temps réel sur le comportement d’une audience dans un lieu physique. En effet, ils permettent à des participant·es d’interagir avec une installation artistique sans devoir passer par l’intermédiaire d’une manette ou des boutons de contrôle.

Ce n’est pas pour rien, donc, qu’une multitude de studio créatif montréalais acquièrent des outils logiciels pour la conception de systèmes interactifs qui implique l’utilisation de ces capteurs. Pensons au pionnier de l’architecture immersive, Moment Factory, qui possède une solution sur mesure pour le développement de jeux interactifs sur les planchers (qui est notamment intégrée dans l’installation ARcade, au Casino de Montréal). De son côté, le studio Iregular a récemment fait la promotion de son outil développé à l’interne, Cursor, qui est utilisé dans ses installations. Sinon, Ottomata développe sa technologie OTTO_TRACK pour le suivi de participant·es dans des grands espaces, et le Lab148 développe pose.cpp, un outil pour la détection de squelettes sur image.

Page couverture du guide pour une démocratisation de l’utilisation de la capture de mouvement dans les arts vivants.

Vers une interaction partagée : l’interaction collective

Au cours des quinze dernières années, plusieurs chercheur·cheuses et développeur·euses de la SAT ont contribué au développement d’outils logiciels visant à intégrer des technologies de captation dans des expériences immersives et collaboratives. En 2012, des chercheur·euses et développeur·euses de la SAT se penchaient déjà sur le développement de PostureVision, un outil logiciel permettant la fusion de données provenant de plusieurs caméras de profondeur et la transmission de vidéo volumétrique d’un lieu physique à un autre. Ce travail sur la fusion de données permet d’agencer des flux vidéos de caméras captant une même scène et a notamment été utilisé dans l’installation de téléprésence The Drawing Space (2013), permettant à des participant·es situé·es à différents endroits sur la planète de créer des environnements virtuels partagés.

Pour le Département de l’innovation de la SAT, la recherche en interaction collective mobilise le développement et l’intégration de technologies d’interactivité au service de la scénarisation d’expériences immersives. Les avancées en interaction collective visent ainsi à enrichir le vocabulaire par lequel s’établit le dialogue entre les participant·es d’une expérience immersive interactive.

Plusieurs travaux de la SAT portent sur l’intégration de systèmes de vision par ordinateur adaptés au contexte d’installations artistiques. Certains de ces systèmes utilisent, par exemple, la détection de blobs sur image, ce qui permet de localiser des sources de lumière dans un espace. Dans un contexte d’expérience immersive, ces sources peuvent provenir des lumières de téléphone des participant·es et être utilisées afin de créer des interactions entre les déplacements du public et des éléments visuels. Les modèles de détection basés sur l’apprentissage machine sont également intéressants pour des applications artistiques. Les modèles spécialisés dans la détection de pose humaine, par exemple, peuvent être utilisés pour reconnaître différents gestes effectués par des participant·es, et déclencher divers contenus multimédias.

PointMapper : Un ajout à la boîte à outil SAT pour les besoins de l’écosystème

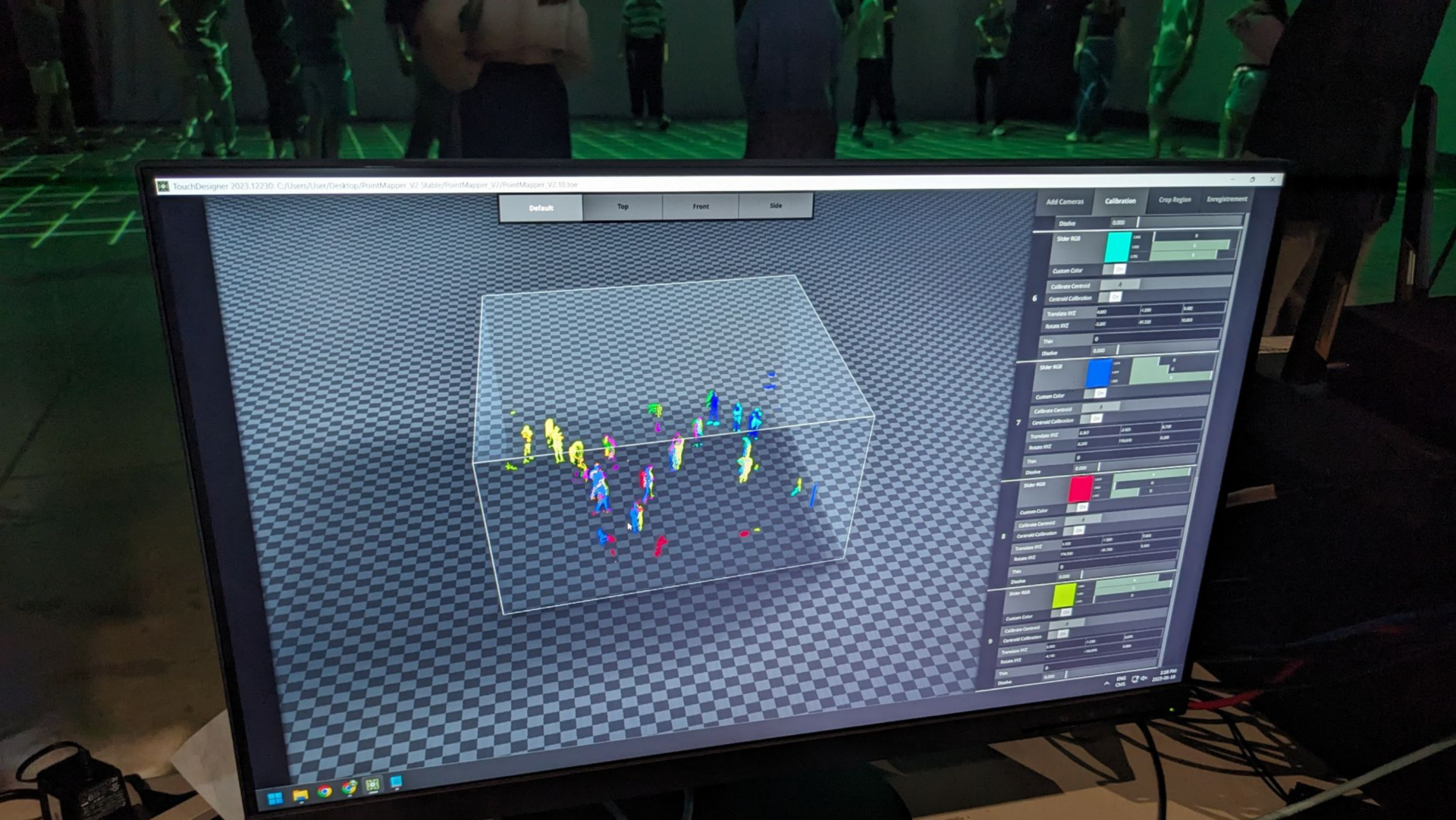

Capture d’écran de l’outil PointMapper. La position des gens sur le plancher est représentée par les différents blob de couleurs sur l’interface visuelle.

Aujourd’hui, l’équipe de recherche en interaction collective concentre ses efforts sur l’amélioration des systèmes de détection adaptés à des contextes de déploiement à grande échelle. L’objectif est de rendre ces technologies suffisamment robustes pour les intégrer dans des performances réunissant de vastes foules, dans le but de favoriser leur adoption par les industries culturelles et créatives.

C’est dans cette optique que PointMapper a été développé. PointMapper est un prototype d’outil de calibration spatiale capable de fusionner en temps réel les données de profondeur provenant de plusieurs capteurs. En recombinant les flux de caméras dans un environnement de visualisation 3D, PointMapper permet de visualiser l’activité humaine dans un lieu physique en temps réel. Conçu pour fonctionner en contexte de performance live, PointMapper se distingue par sa facilité d’utilisation et par sa compatibilité avec les environnements de création déjà adoptés par l’écosystème, tels que TouchDesigner.

L’outil a pu être testé en conditions réelles lors d’un projet réalisé en collaboration avec le LAB7 des 7 Doigts de la main visant à accompagner trois projets dans le cadre du prototypage de performances à la croisée des arts vivants et de la technologie. PointMapper a permis de déclencher des effets visuels sur le plancher interactif du collectif BEATS lors de sa présentation de sortie d’accompagnement artistique, qui a réunit plus de 150 participant·es. La surface captée était de 40 mètres par 20 mètres et était couverte par neuf flux de caméras gérés en simultané.

La collaboration avec le LAB7 ouvre la porte à plusieurs autres mises en application de PointMapper. Déjà, PointMapper a été intégré au studio de son de la SAT, afin de déplacer des sources sonores dans l’espace en fonction de la position des individus. L’outil permettra également d’assurer l’interactivité de l’installation CiÖ_Echos, présentée à la Galerie SAT du 5 au 25 septembre prochain par le Collectif CiÖ.