- La vie, la mort, le dessertSatosphèreDates: Du 18 au 21 février et du 25 au 28 février

Plusieurs dates à venir en novembre et décembre

Heure: 18h

Durée: environ 3h

Les représentations prévues du 20 au 28 février rejoignent officiellement la programmation gourmande de Montréal en Lumière. - Club SAT x Groovy Castle — Fred Everything • Lia Plutonic • JP GrooveEspace SAT22h-3h

Scénophonie : Une approche allocentrique de l'immersion sonore

Le projet « Scénophonie : développement méthodologique et logiciel dans l’écosystème SAT (boîte à outils) pour l’exploration de systèmes de spatialisation sonore immersifs décentralisés » s’inscrit dans une démarche de validation artistique et théorique de la scénophonie. Celle-ci est entendue comme un processus visant à composer et structurer la scène en prenant en compte l’expérience sonore visée, dans une démarche orientée vers la perception. Ce projet vise à démontrer qu’une expérience sonore se conçoit non seulement à partir des signaux audio émis par des haut-parleurs, mais aussi à travers l’ensemble des stimuli sensoriels perçus dans un environnement acoustique, incluant la réponse propre d’un espace architectural spécialement configuré.

L’hypothèse est que la scénophonie ne consiste pas seulement à définir le champ audible auquel l’auditoire est exposé durant l’expérience, c’est-à-dire l’ensemble des sons possibles, mais aussi à déterminer ce qu’il est nécessaire de ne pas lui faire entendre. Elle déterminerait donc l’ensemble des choix artistiques et techniques liés à la création, à l’orchestration, à l’amplification, à la diffusion et à la spatialisation du son, dans le but d’offrir au public une expérience auditive optimale.

Voici les différentes étapes et résultats du projet :

1. Un état de l’art approfondi des techniques et des besoins du milieu

Nous avons d’abord réalisé un état de l’art des technologies de spatialisation sonore existantes, combiné à une série d’entrevues menées auprès d’une dizaine d’artistes, de technicien·ne·s de son et de chercheur·euse·s.

Ce que nous avons fait :

- Cartographier les techniques de spatialisation (VBAP/MBAP/HOA/WFS, etc.), de leurs forces, leurs faiblesses et leurs implications psychoacoustiques (sweetspot égocentrique vs zones d’écoute collective ou allocentrique).

- Analyser les méthodes de contrôle et d’affichage pour identifier ce qui facilite l’assimilation et l’efficacité en création.

- Clarifier les formats et workflows de transfert pour l’audio immersif afin d’assurer la portabilité des œuvres entre différents contextes d’écoute (studio, diffusion, casque).

- Recueillir des verbatims d’artistes/technicien·nes/chercheur·euses pour ancrer les constats dans les besoins réels (accompagnement, interopérabilité, pérennité des œuvres).

Ce que nous avons constaté :

- La plupart des techniques s’appuyant sur un point d’écoute idéalisé (sweetspot) offrent une forte précision au centre de la scène, mais imposent une géométrie d’enceintes et une disposition d’audience contraignantes.

- En matière d’outillage, la lisibilité des interfaces 3D et la standardisation des gestes de contrôle sont déterminantes pour l’apprentissage. L’utilisation de gabarits et de scènes types permet ainsi de réduire significativement la courbe d’entrée.

- Les entretiens pointent un écart marqué entre le travail en studio et la diffusion (variabilité des lieux), ainsi qu’un besoin de langage commun et de workflows légers pour accélérer la création et la transmission.

Cette enquête a permis de mettre en lumière les besoins concrets du milieu, les limites des outils actuels et des opportunités claires de développement.

2. Un développement technologique en soutien à l’écosystème open source

En parallèle, une phase de R&D a été amorcée pour mettre à niveau la boîte à outils sonores de la SAT, en s’appuyant sur des technologies libres existantes.

Cette démarche, ancrée dans une logique de collaboration et d’interopérabilité, a notamment permis de développer de nouvelles fonctionnalités dans l’environnement de spatialisation du Groupe de recherche en immersion sonore (GRIS). Parmi celles-ci figurent la création de groupes de haut-parleurs dans l’espace et le traitement parallèle de l’audio, qui permet la spatialisation d’un plus grand nombre de sources.

Voici une liste des accomplissements pour les différentes composantes logicielles de spatialisation :

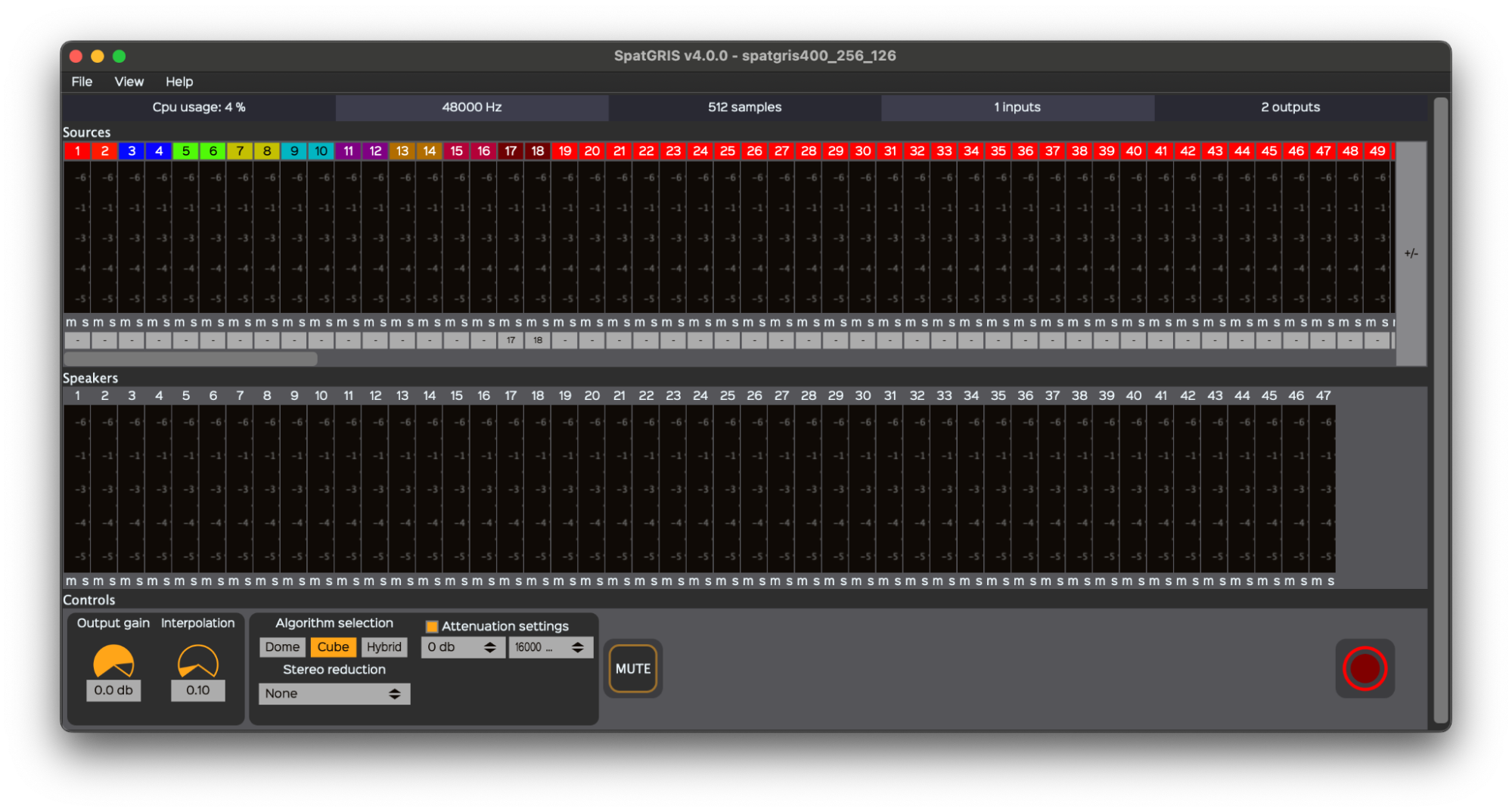

SpatGRIS

- Mise en place d’une pipeline GitHub actions, avec signature de code et intégration de rtsan pour valider le traitement temps-réel de l’application.

- Création d’AlgoGRIS, incluant des vérifications pre-commit, des tests unitaires audio, et des benchmarks de performance des algorithmes de spatialisation, avec un site web pour afficher les résultats.

- Nouvelles fonctionnalités dans la fenêtre Speaker Setup Edition Window :

– Introduction de l’utilisation de value trees pour une gestion des données plus flexible, notamment avec l’intégration de fonction undo et redo.

– Ajout de groupes de haut-parleurs (incluant des polyèdres et des grilles) permettant de déplacer solidairement plusieurs haut-parleurs dans l’espace.

- Mise à jour de JUCE 8.

- Optimisation de la communication entre SpatGRIS et SpeakerView pour la rendre moins intensive, grâce à des algorithmes plus efficaces et à une réduction du volume de données transmises.

- Ajout de ports de communication permettant de connecter SpatGRIS avec une instance de SpeakerView ouverte sur un autre appareil sur le même réseau.

- Ajout des configurations de haut-parleurs conformes aux normes ITU-R BS.775, BS.2051 et BS.2094-2

- Introduction d’une option de traitement parallèle des signaux audio pour optimiser la capacité effective de gestion simultanée des entrées et sorties, grâce à l’utilisation de la librairie fork_union.

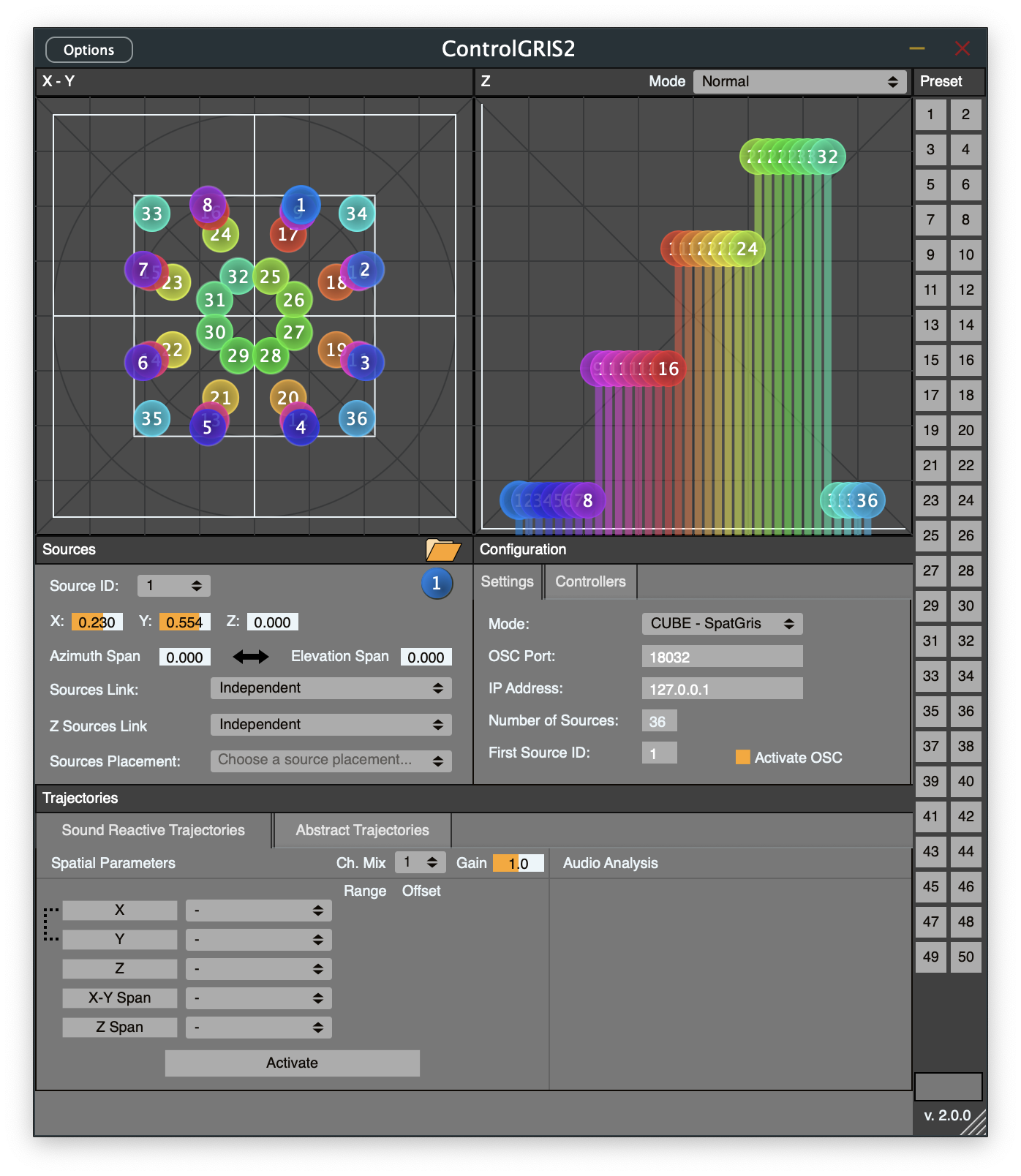

ControlGRIS

- Ajout d’une pipeline GitHub Actions.

- Ajout d’un mode ControlGRIS standalone, où l’application fonctionne de manière autonome plutôt qu’en tant que plugiciel.

- Augmentation du nombre maximal de sources à 256.

- Importation de speaker setups comme positions de sources.

- Sauvegarde du nombre de sources et de l’identifiant de la première source (first source ID) dans les presets.

- Utilisation de rtsan pour identifier et régler plusieurs problèmes liés au traitement audio en temps-réel.

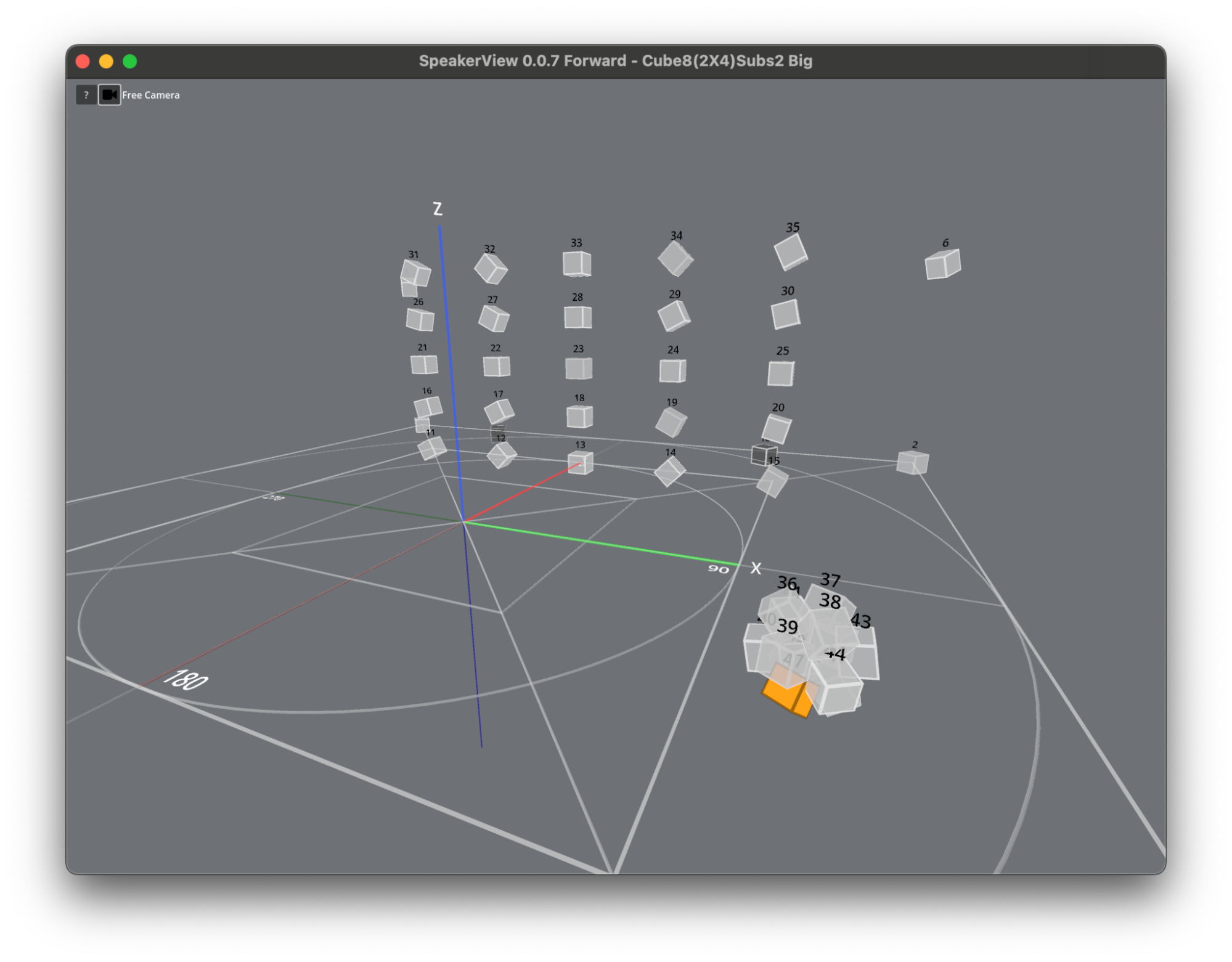

SpeakerView

- Ajout d’une pipeline GitHub Actions

- Ajout d’une nouvelle caméra libre pour se déplacer dans l’espace 3D.

- Ajout d’une caméra fulldome.

- Redimensionnement dynamique des haut-parleurs lorsqu’ils sont regroupés, afin de mieux visualiser les ensembles.

- Intégration d’un menu d’aide pour montrer les raccourcis clavier.

- Mise à jour de Godot 4.5.

- Ajout d’options pour spécifier les ports UDP d’entrée et sortie.

- Possibilité de faire fonctionner SpeakerView en mode autonome, sans qu’il soit lancé depuis SpatGRIS.

- Résolution d’une condition de course entre les options d’affichage de SpeakerView et SpatGRIS.

Pour en savoir plus sur ces développements, visitez le GitHub de SpatGRIS.

3. L’élaboration d’un processus scénophonique appliqué

S’appuyant sur les travaux de thèse du chercheur-intégrateur David Ledoux, une méthodologie scénophonique a été formulée. Elle propose un cadre de travail interdisciplinaire favorisant le dialogue et la traduction entre les différents corps de métier impliqués dans la création sonore immersive. Cette méthodologie a été mise à l’épreuve à travers quatre accompagnements artistiques réalisés à l’été 2025, ainsi qu’une formation pilote tenue en septembre 2025, réunissant une première cohorte de quinze participant·e·s.

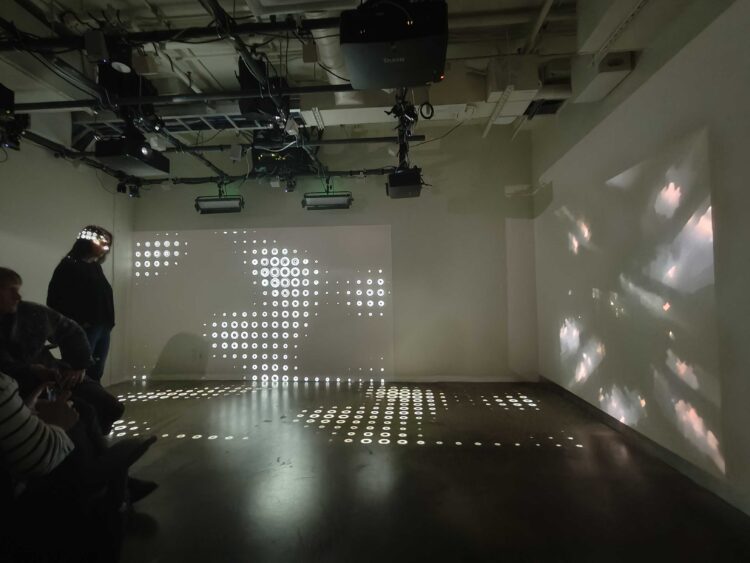

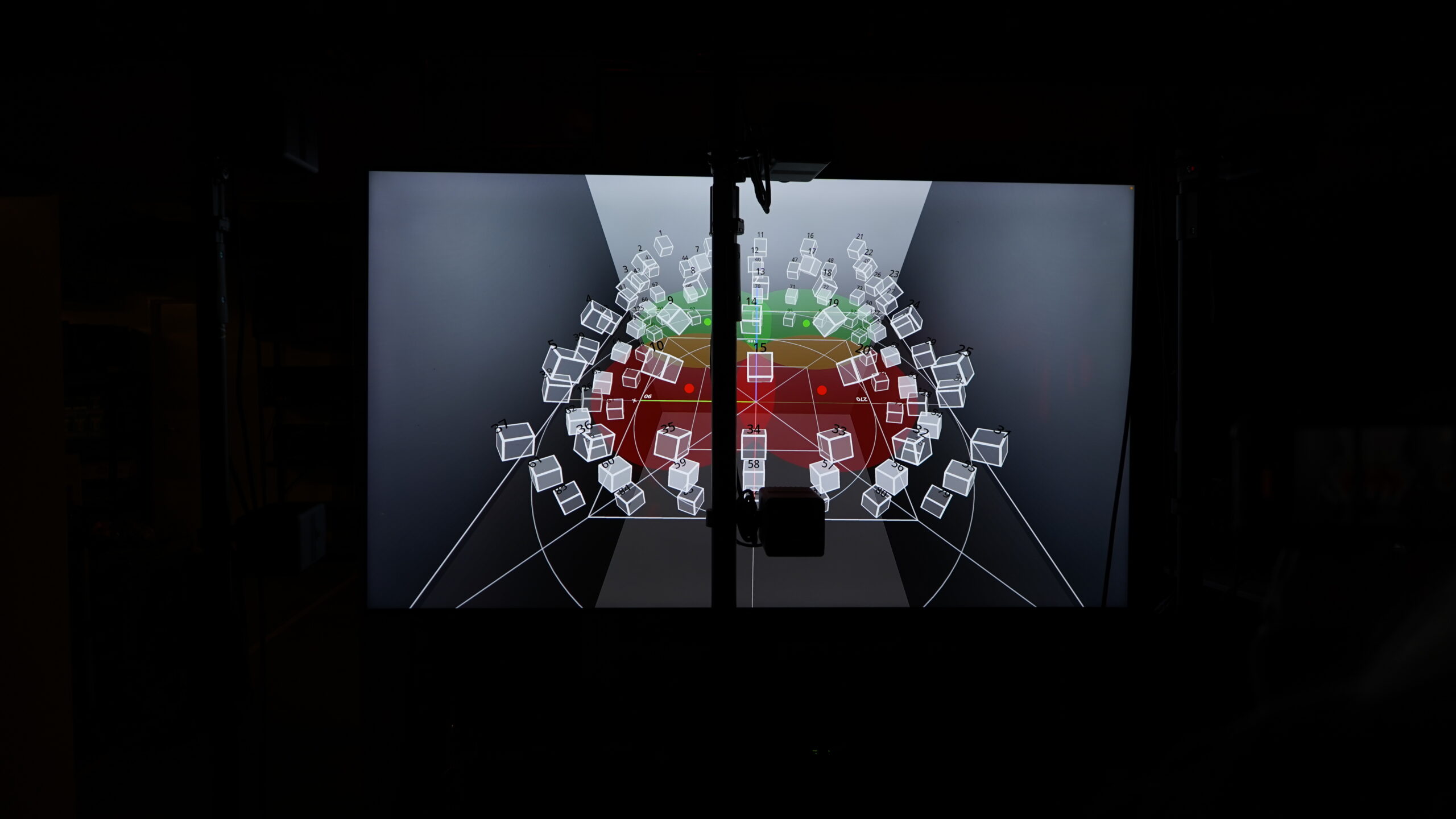

4. La création d’un studio de son dédié à l’expérimentation sonore spatialisée

Conçu comme un simulateur d’environnement acoustique, le studio de son de la SAT offre un dispositif modulaire de diffusion allocentrique, qui n’impose ni orientation, ni position corporelle d’écoute dominante (sweetspot). Il s’adapte donc à une diversité de besoins :

- Location : espace locatif pour simuler ou peaufiner des rendus sur haut-parleurs virtuels.

- Formation : espace de formation et de démonstrations en immersion sonore.

- Production : espace de travail accessible aux artistes sonores en résidence.

- Innovation : laboratoire de recherche dédié à l’exploration et la validation expérimentales.

Le studio de son est un espace de 5,75m x 6m x 2,6m de diamètre dédié à l’expérimentation sonore, situé au sous-sol de la SAT

Il est composé de 97 haut-parleurs Meyer Sound MM-4XP, disposés en cube, et de 4 subwoofers MM10, configurés en double-bass array. Le studio permet d’exploiter jusqu’à 27 canaux de sortie analogiques supplémentaires, avec la possibilité d’ajouter des haut-parleurs au sol ou à l’intérieur de l’espace.

Le studio comprend jusqu’à 32 entrées audio analogiques de niveau ligne, dont 8 entrées micro avec préamplification, permettant l’intégration de sources externes.

Outre la connectivité analogique, le studio offre une acquisition audionumérique jusqu’à 512 canaux, via USB-A 2.0, Thunderbolt 3.0 ou Ethernet gigabit (Dante ou AES67), ainsi que des pilotes audio compatibles avec les plateformes macOS, Windows et Linux.

Le studio est également équipé d’un système de capture de mouvement corporel, permettant notamment une interaction en temps réel avec la spatialisation sonore, au besoin.

Écrivez-nous pour en savoir plus sur nos résultats de recherche, et pour discuter ensemble des possibilités que peuvent ouvrir la scénophonie dans vos projets !

Glossaire - Quelques notions et mots clés en spatialisation sonore

Scénophonie

Néologisme dérivé du terme « scénographie », la « scénophonie » désigne la conception et la réalisation d’espaces esthétiques (scéniques) dans une perspective sonore (phonique), telles que perçues par le public. Alors que la scénographie intègre parfois la dimension sonore, elle demeure généralement dominée par l’ensemble visible de l’espace de la scène. La scénophonie peut donc être comprise comme une scénographie focalisée sur le sonore.

Spatialisation sonore

Technique qui consiste à organiser la diffusion du son dans l’espace, afin de donner une impression de localisation, de profondeur ou de mouvement sonore.

Binaural

Technique de spatialisation simulée à partir d’un enregistrement ou d’un traitement audio en deux canaux (gauche/droite), destinée à être écoutée au casque. Elle reproduit la manière dont nos oreilles perçoivent les sons dans l’espace, avec un haut niveau de réalisme, mais demeure individuelle et isolante.

Ambisonie

Méthode de spatialisation basée sur la représentation mathématique d’un champ sonore en 3D, indépendante du nombre et de la disposition des haut-parleurs. Très puissante, elle nécessite souvent des configurations complexes (dômes, implantation sphérique) et un point d’écoute optimal.

Sweet spot (ou “place du prince”)

Position idéale dans l’espace d’écoute où l’effet de spatialisation est le plus précis. Plus on s’éloigne de ce point, plus la qualité de l’immersion diminue, ce qui peut poser un problème dans le cadre d’expériences collectives.

Modèle égocentrique

Approche de spatialisation centrée sur la perspective d’un·e auditeur·rice unique, souvent statique, comme dans l’écoute en réalité virtuelle au casque ou lors de concerts en surround classique.

Modèle allocentrique

Approche de spatialisation décentrée, qui prend en compte la diversité des points de vue dans l’espace. Elle vise à créer une expérience immersive collective, fluide et ouverte à différents positionnements physiques et sensoriels.

Concentrique

Disposition spatiale dans laquelle les sources sonores ou les haut-parleurs sont orientés vers un centre commun, généralement autour du public. Ce modèle permet une immersion enveloppante, mais reste sensible à la position exacte de l’auditeur·rice.

Frontal

Modèle classique de diffusion sonore orienté vers le public, comme au théâtre ou en concert. Le son émane d’une direction principale, avec peu ou pas de spatialisation latérale ou arrière.

AUDIODICE

Enceinte polyédrique (dodécaèdre) composée de 12 haut-parleurs indépendants, développée par la SAT. Elle permet une diffusion sonore volumique, multidirectionnelle et divergente, adaptée aux installations immersives et aux environnements non conventionnels.

Pourquoi choisir la SAT?

• Un centre de recherche public agréé par le gouvernement du Québec

• Un accompagnement personnalisé suivant une méthodologie de laboratoire vivant, centrée sur l’utilisateur

• Un écosystème de logiciels libres polyvalents et accessibles

• Un service de soutien en innovation éligible à un crédit d’impôt remboursable pour la R&D.